5月13日OpenAI发布会,并没有发布GPT-5,没有发布ChatGPT搜索,而是正式发布GPT-4o!

GPT-4o(o代表omni)是迈向更自然的人机交互的一步——它接受文本、音频和图像的任意组合作为输入,并生成文本、音频和图像的任意组合输出。它可以在短至 232 毫秒的时间内响应音频输入,平均为 320 毫秒,与人类的响应时间相似(在新窗口中打开)在一次谈话中。它在英语文本和代码上的性能与 GPT-4 Turbo 的性能相匹配,在非英语文本上的性能显着提高,同时 API 的速度也更快,成本降低了 50%。与现有模型相比,GPT-4o 在视觉和音频理解方面尤其出色。

总结内容

新的 GPT-4o 模型:打通任何文本、音频和图像的输入,相互之间可以直接生成,无需中间转换

GPT-4o 语音延迟大幅降低,能在 232 毫秒内回应音频输入,平均为 320 毫秒,这与对话中人类的响应时间相似

GPT-4o 向所有用户免费开放 4.GPT-4o API,比 GPT 4-Turbo 快 2 倍,价格便宜 50%

惊艳的实时语音助手演示:对话更像人、能实时翻译,识别表情,可以通过摄像头识别画面写代码分析图表

ChatGPT 新 UI,更简洁

一个新的 ChatGPT 桌面应用程序,适用于 macOS,Windows 版本今年晚些时候推出

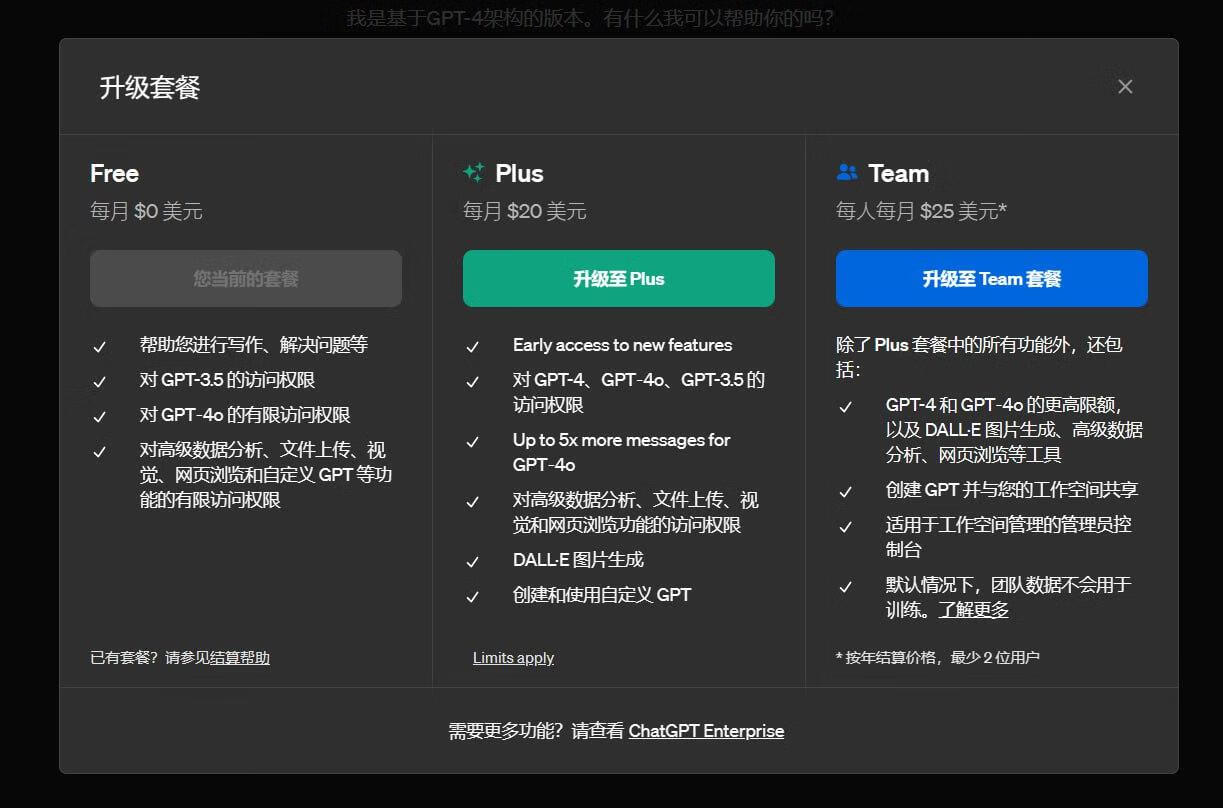

计费价格

下面是目前OpenAI几个重要模型的价格比较!一目了然!

使用体验

目前GPT Plus用户已经可以体验GPT-4o模型了,免费用户应该需要再等等!

GPT-4o模型对话容量方面,参考如下:

GPT-4o模型对话容量方面,参考如下:

普通用户 16条消息 每3小时

Plus用户 80条消息 每3小时

Team用户 更高的消息条数

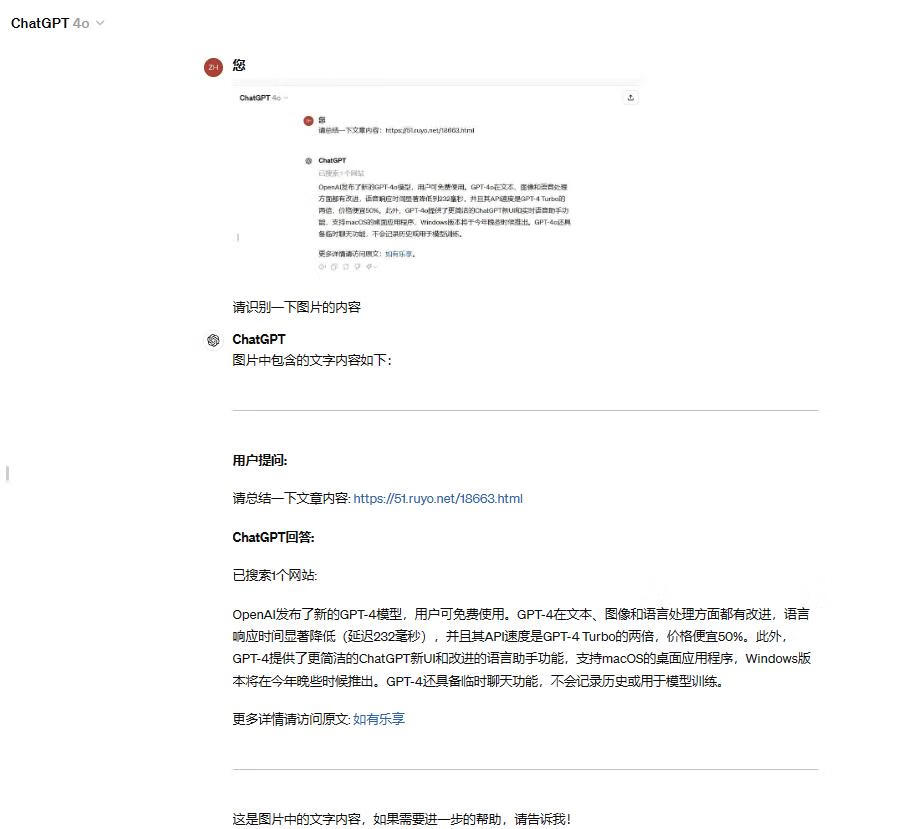

支持网络访问,速度很快!

支持图片文字提取!

目前回答的速度非常快!

我是ChatGPT,基于OpenAI的GPT-4架构。虽然我属于GPT-4系列,但具体的性能和能力与其他模型版本相比可能有所不同。我能够处理各种自然语言任务,包括回答问题、提供建议、编写文章等。如果你有任何具体的问题或任务,请告诉我,我会尽力帮你解决。

"GPT-4o"中的“o”通常表示优化版本(optimized)。这种版本在性能、效率或其他特定方面可能经过了特别的改进或优化,以便在特定应用场景中表现得更好。不过,具体的含义可能会因具体版本或发布情况而有所不同,建议参考官方文档或公告获取准确信息。

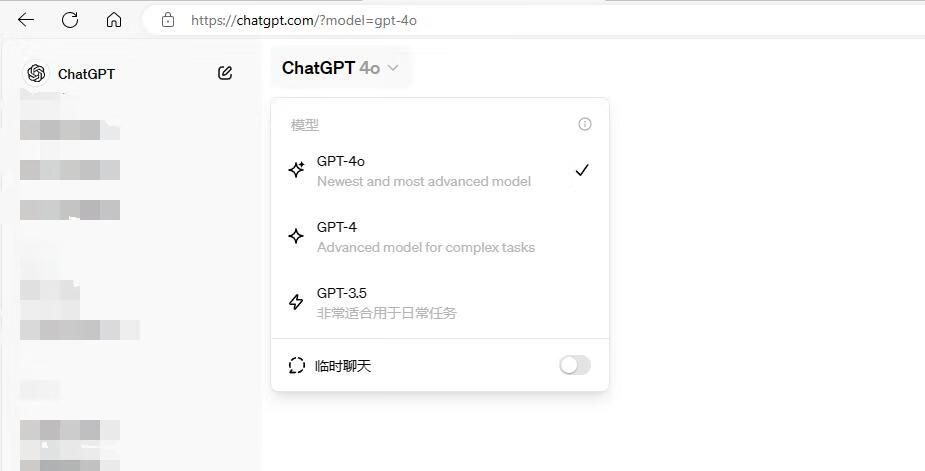

可见界面上除了 GPT-4o 还多了一个临时聊天功能。

不包含在历史记录中

临时聊天不会出现在您的历史记录中。出于安全考虑,我们可能会保留您的聊天记录最多30天。

不会用于模型训练

临时聊天不会被用来改进我们的模型。

记忆关闭

ChatGPT 不会在临时聊天中使用或创建记忆。系统仍然会遵循您的自定义指令(如有)。

免费使用

官方宣布所有用户(OpenAI注册用户) 都可使用!目前Plus用户已经可以使用了!其他用户需要多等等!

评论